Il 2012 ha rappresentato un anno di grandi cambiamenti per la SEO con Google che ha rilasciato aggiornamenti algoritmici significativi capaci di rivoluzionare le strategie di posizionamento premiando chi produce contenuti di qualità e penalizzando severamente chi utilizza tecniche manipolative. I siti che non si sono adattati ai nuovi criteri hanno visto crollare il proprio traffico organico perdendo visibilità costruita nel corso di anni, mentre chi ha abbracciato un approccio etico e centrato sull’utente ha beneficiato di posizionamenti più stabili e duraturi. Comprendere le best practice SEO aggiornate permette di costruire presenza sui motori di ricerca che resiste ai futuri aggiornamenti perché basata su principi fondamentali di qualità invece che su exploit temporanei destinati a essere chiusi.

Gli aggiornamenti Panda e Penguin

Google Panda rilasciato nel 2011 e aggiornato ripetutamente nel 2012 ha preso di mira i siti con contenuti di bassa qualità, duplicati da altre fonti, con troppa pubblicità nella parte visibile della pagina, pagine con poco contenuto originale che non offrono valore reale agli utenti, e le cosiddette content farm che producevano enormi quantità di articoli superficiali ottimizzati solo per le keyword senza preoccuparsi di rispondere effettivamente alle domande degli utenti. Google Penguin lanciato ad aprile 2012 ha invece colpito chi utilizzava tecniche di link building manipolative: link a pagamento non dichiarati come tali, schemi di scambio link organizzati per gonfiare artificialmente la popolarità, link provenienti da directory di bassa qualità create solo per questo scopo, e anchor text sovraottimizzato che ripeteva ossessivamente le stesse keyword. Questi aggiornamenti hanno segnato un cambio di paradigma dove le scorciatoie che funzionavano in passato sono diventate non solo inefficaci ma attivamente dannose.

Ricerca delle parole chiave

La keyword research rappresenta il fondamento di qualsiasi strategia SEO efficace perché permette di identificare cosa cercano effettivamente gli utenti e quali termini offrono il miglior equilibrio tra volume di ricerca e possibilità di posizionamento. Il Google Keyword Tool fornisce dati sui volumi di ricerca mensili permettendo di stimare il traffico potenziale per ogni keyword, mentre l’analisi della concorrenza rivela quanto sarà difficile posizionarsi per termini specifici osservando chi occupa attualmente le prime posizioni. La strategia vincente combina keyword generiche ad alto volume ma alta competizione con keyword long-tail più specifiche che attirano meno ricerche ma permettono posizionamenti più facili e spesso convertono meglio perché raggiungono utenti con intenti più definiti. L’intento di ricerca merita particolare attenzione: capire se l’utente cerca informazioni, vuole acquistare, o cerca un sito specifico determina il tipo di contenuto necessario per soddisfare la ricerca e quindi posizionarsi efficacemente.

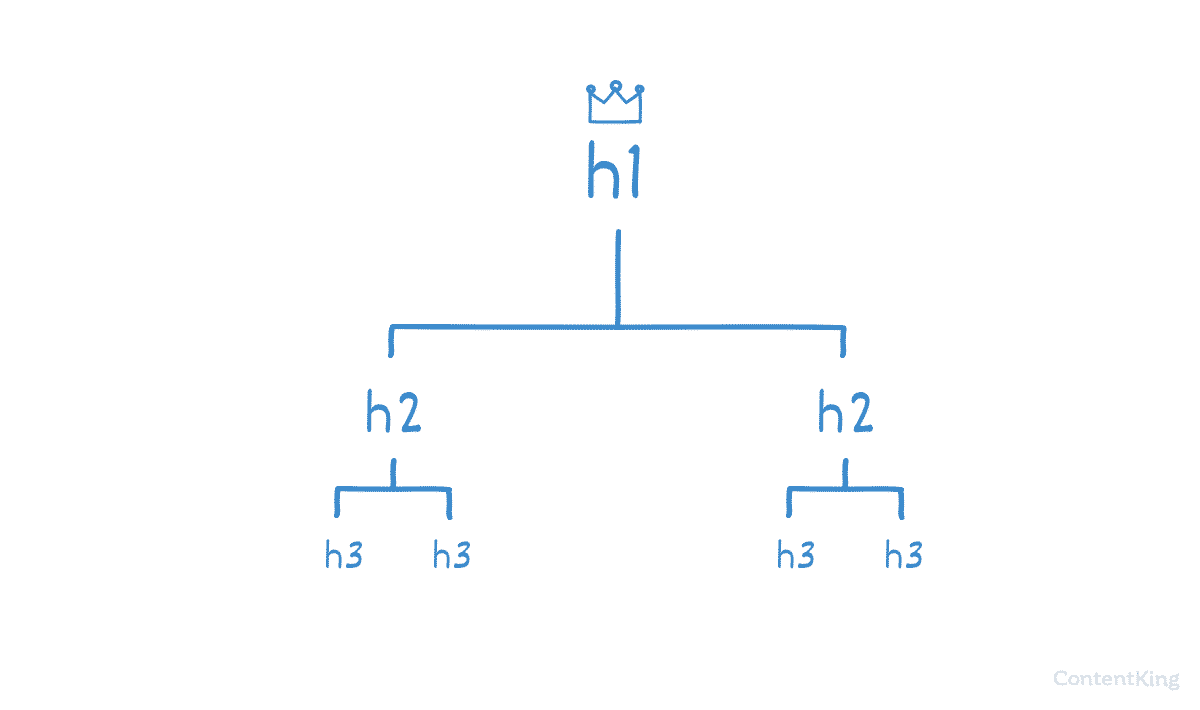

Ottimizzazione on-page

Il title tag rappresenta il fattore on-page più importante e deve essere ottimizzato inserendo la keyword principale preferibilmente all’inizio, mantenendo una lunghezza tra cinquanta e sessanta caratteri per evitare troncamenti nei risultati di ricerca, rendendo il titolo accattivante per aumentare il click-through rate, e assicurando che ogni pagina del sito abbia un title unico che descriva specificamente quel contenuto. La meta description non influisce direttamente sul ranking ma è fondamentale per convincere gli utenti a cliccare: una descrizione persuasiva di centocinquanta-centosessanta caratteri che include la keyword principale e contiene una call to action può fare la differenza tra un click guadagnato e uno perso verso un concorrente. La struttura degli heading con H1, H2 e H3 deve seguire una gerarchia logica con un solo H1 per pagina contenente la keyword principale, H2 per le sottosezioni principali, e H3 per ulteriori suddivisioni, creando un documento ben organizzato che sia facilmente scansionabile da utenti e motori di ricerca.

Contenuti di qualità dopo Panda

Dopo l’aggiornamento Panda la qualità dei contenuti è diventata assolutamente cruciale: non basta più produrre pagine ottimizzate tecnicamente se il contenuto non offre valore reale agli utenti che lo leggono. I contenuti devono essere originali senza copiare o parafrasare superficialmente altre fonti, approfonditi andando oltre l’ovvio per rispondere completamente alle domande degli utenti, e regolarmente aggiornati perché informazioni obsolete danneggiano sia l’esperienza utente che la percezione di qualità da parte di Google. La lunghezza minima si aggira intorno alle trecento parole per pagina, ma contenuti più lunghi di ottocento o più parole tendono a posizionarsi meglio perché possono trattare gli argomenti in modo più completo. L’obiettivo non è riempire pagine con parole inutili ma fornire tutto ciò che l’utente potrebbe voler sapere sull’argomento, rispondendo alle domande correlate e anticipando i dubbi che potrebbero sorgere durante la lettura.

Link building etica dopo Penguin

Dopo Penguin le strategie di link building devono essere naturali e basate sulla qualità invece che sulla quantità, abbandonando definitivamente tecniche che cercano di manipolare gli algoritmi in favore di approcci che meritano i link ricevuti. Il guest posting su siti autorevoli del proprio settore permette di raggiungere nuovi pubblici mentre si guadagnano link editoriali di qualità, richiedendo la produzione di contenuti genuinamente utili per il pubblico del sito ospitante invece di articoli promozionali mascherati. La creazione di contenuti linkabili come infografiche, guide complete, ricerche originali con dati esclusivi attira link naturalmente perché offre risorse che altri siti vogliono citare e condividere con i propri lettori. Le digital PR con comunicati stampa distribuiti a media rilevanti, interviste a pubblicazioni di settore, e citazioni come esperti costruiscono visibilità e link contemporaneamente. Acquistare link, partecipare a schemi di scambio massivo, utilizzare directory di bassa qualità, e commentare con link spam sono pratiche da evitare assolutamente perché portano a penalizzazioni che possono essere difficili da recuperare.

SEO tecnica e strumenti essenziali

La velocità di caricamento del sito è diventata un fattore di ranking riconosciuto che influenza sia il posizionamento che l’esperienza utente, richiedendo ottimizzazione delle immagini per ridurne il peso senza sacrificare troppo la qualità, abilitazione della compressione GZIP sul server, minimizzazione di CSS e JavaScript per ridurre le dimensioni dei file, e scelta di un hosting performante che risponda rapidamente alle richieste. Gli URL devono essere ottimizzati risultando brevi e descrittivi, contenendo la keyword principale, usando trattini per separare le parole, ed evitando parametri e numeri inutili che non comunicano nulla sul contenuto della pagina. La sitemap XML creata e inviata a Google Webmaster Tools facilita l’indicizzazione assicurando che tutte le pagine vengano scoperte dai crawler. Gli strumenti essenziali per ogni SEO includono Google Webmaster Tools per monitorare indicizzazione ed errori, Google Analytics per analizzare il traffico e il comportamento degli utenti, Google Keyword Tool per la ricerca delle parole chiave, Screaming Frog per audit tecnici completi, e Open Site Explorer per l’analisi dei backlink propri e dei concorrenti.

Un approccio sostenibile nel tempo

La SEO nel 2012 e oltre richiede un approccio etico e orientato alla qualità che abbandona definitivamente la mentalità delle scorciatoie e dei trucchi per abbracciare una visione di lungo termine dove il successo deriva dal meritare genuinamente le prime posizioni. Le tecniche manipolative non funzionano più perché Google è diventato sempre più bravo a identificarle e penalizzarle, mentre chi costruisce siti utili, contenuti di valore e relazioni autentiche nel proprio settore beneficia di posizionamenti stabili che resistono agli aggiornamenti algoritmici. La concentrazione deve essere sulla creazione di contenuti che rispondono veramente alle domande degli utenti meglio di qualsiasi altro risultato disponibile, sulla costruzione di relazioni genuine che portano a menzioni e link naturali, e sull’ottimizzazione tecnica che permette a Google di comprendere e indicizzare correttamente i contenuti. I risultati richiedono più tempo rispetto alle tecniche aggressive del passato, ma la stabilità e la sostenibilità delle posizioni guadagnate eticamente compensano ampiamente la pazienza richiesta.